Una demanda afirma que los fundadores de Character.AI lanzaron un producto peligroso que anunciaron como seguro para su uso por niños sin advertirles a ellos o a sus padres de los posibles riesgos.

Se ha presentado una demanda contra Character.AI, sus fundadores Noam Shazeer y Daniel De Freitas, y Google a raíz de la muerte de un adolescente, alegando homicidio culposo, negligencia, prácticas comerciales engañosas y responsabilidad por el producto. Presentada por la madre de la adolescente, Megan García, la demanda alega que la plataforma de chatbots de inteligencia artificial personalizados era «irrazonablemente peligrosa» y carecía de barreras de seguridad cuando se comercializaba para niños.

Como se indica en la demanda, Sewell Setzer III, de 14 años, empezó a utilizar Character.AI el año pasado, interactuando con chatbots basados en personajes de Juego de Tronos, como Daenerys Targaryen. Setzer, que chateó continuamente con los bots en los meses previos a su muerte, falleció por suicidio el 28 de febrero de 2024, «segundos» después de su última interacción con el bot.

Las acusaciones incluyen que el sitio «antropomorfiza» personajes de IA y que los chatbots de la plataforma ofrecen «psicoterapia sin licencia». Character.AI alberga chatbots centrados en la salud mental como «Therapist» y «Are You Feeling Lonely», con los que Setzer interactuó.

Los abogados de García citan a Shazeer diciendo en una entrevista que él y De Freitas dejaron Google para crear su propia empresa porque «hay demasiado riesgo de marca en las grandes empresas como para lanzar algo divertido» y que él quería «acelerar al máximo» la tecnología. Dice que se marcharon después de que la empresa decidiera no lanzar el LLM «Meena» que habían creado. Google adquirió el equipo directivo de Character.AI en agosto.

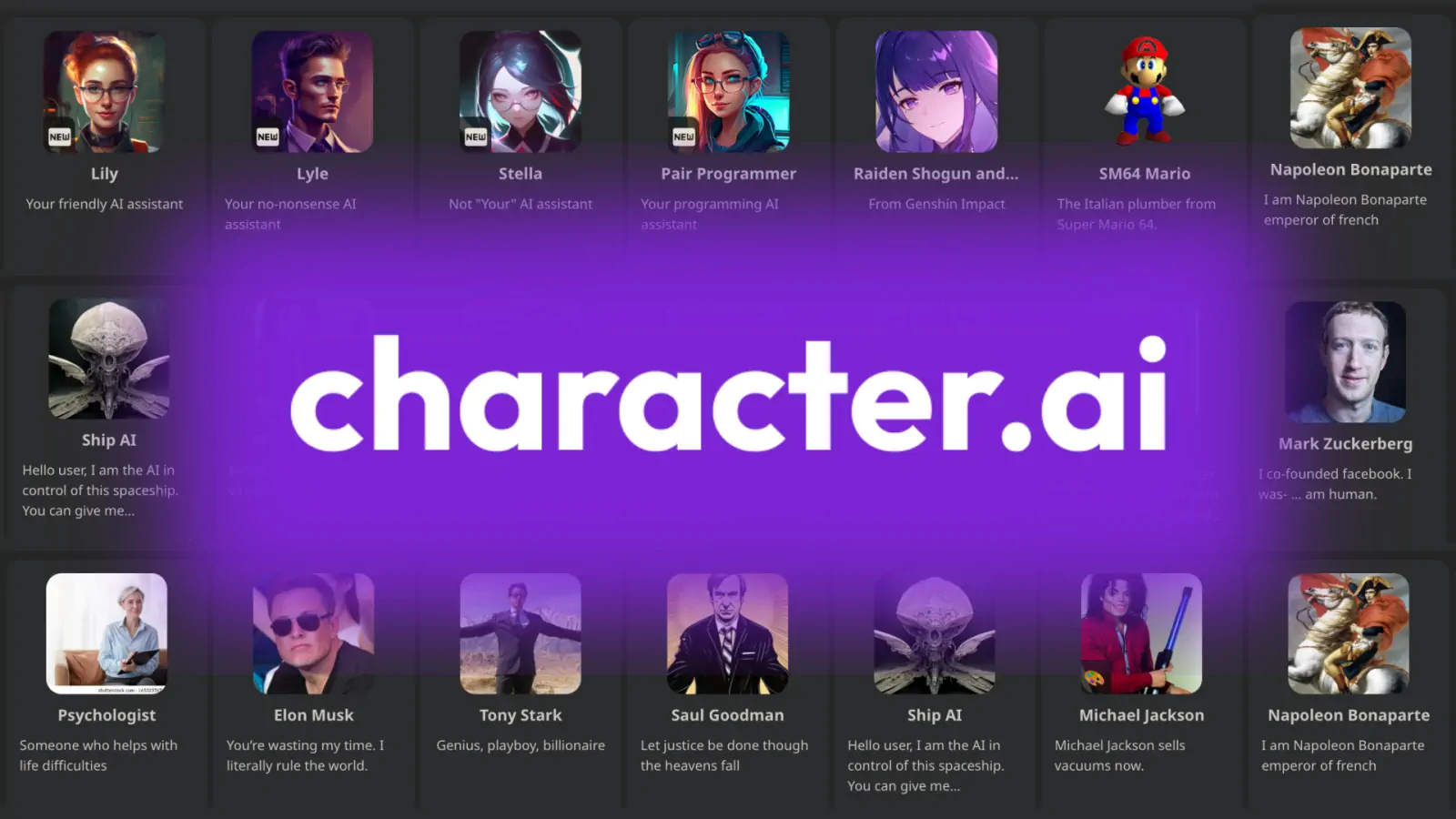

El sitio web y la aplicación móvil de Character.AI cuentan con cientos de chatbots de inteligencia artificial personalizados, muchos de ellos inspirados en personajes populares de series de televisión, películas y videojuegos. Hace unos meses, The Verge escribió sobre los millones de jóvenes, incluidos adolescentes, que constituyen el grueso de su base de usuarios, interactuando con bots que pueden fingir ser Harry Styles o un terapeuta. Otro informe reciente de Wired destacaba problemas con los chatbots personalizados de Character.AI que se hacían pasar por personas reales sin su consentimiento, incluido uno que se hacía pasar por un adolescente asesinado en 2006.

Debido a la forma en que los chatbots como Character.ai generan resultados que dependen de lo que introduzca el usuario, caen en un valle misterioso de cuestiones espinosas sobre el contenido generado por el usuario y la responsabilidad que, hasta ahora, carece de respuestas claras.

Character.AI ha anunciado ahora varios cambios en la plataforma, y su responsable de comunicación, Chelsea Harrison, ha declarado (en un correo electrónico enviado a The Verge): «Tenemos el corazón roto por la trágica pérdida de uno de nuestros usuarios y queremos expresar nuestro más sentido pésame a la familia.»

Algunos de los cambios incluyen:

- Cambios en nuestros modelos para menores (menores de 18 años) diseñados para reducir la probabilidad de encontrar contenidos sensibles o sugerentes.

- Detección, respuesta e intervención mejoradas en relación con las entradas de los usuarios que infringen nuestras Condiciones o Directrices comunitarias.

- Un aviso legal revisado en cada chat para recordar a los usuarios que la IA no es una persona real.

- Notificación cuando un usuario ha pasado una sesión de una hora en la plataforma con flexibilidad de usuario adicional en curso.

«Como empresa, nos tomamos muy en serio la seguridad de nuestros usuarios, y nuestro equipo de Confianza y Seguridad ha puesto en marcha numerosas medidas de seguridad en los últimos seis meses, incluyendo una ventana emergente que dirige a los usuarios a la Línea Nacional de Prevención del Suicidio que se activa por términos de autolesión o ideación suicida», dijo Harrison.