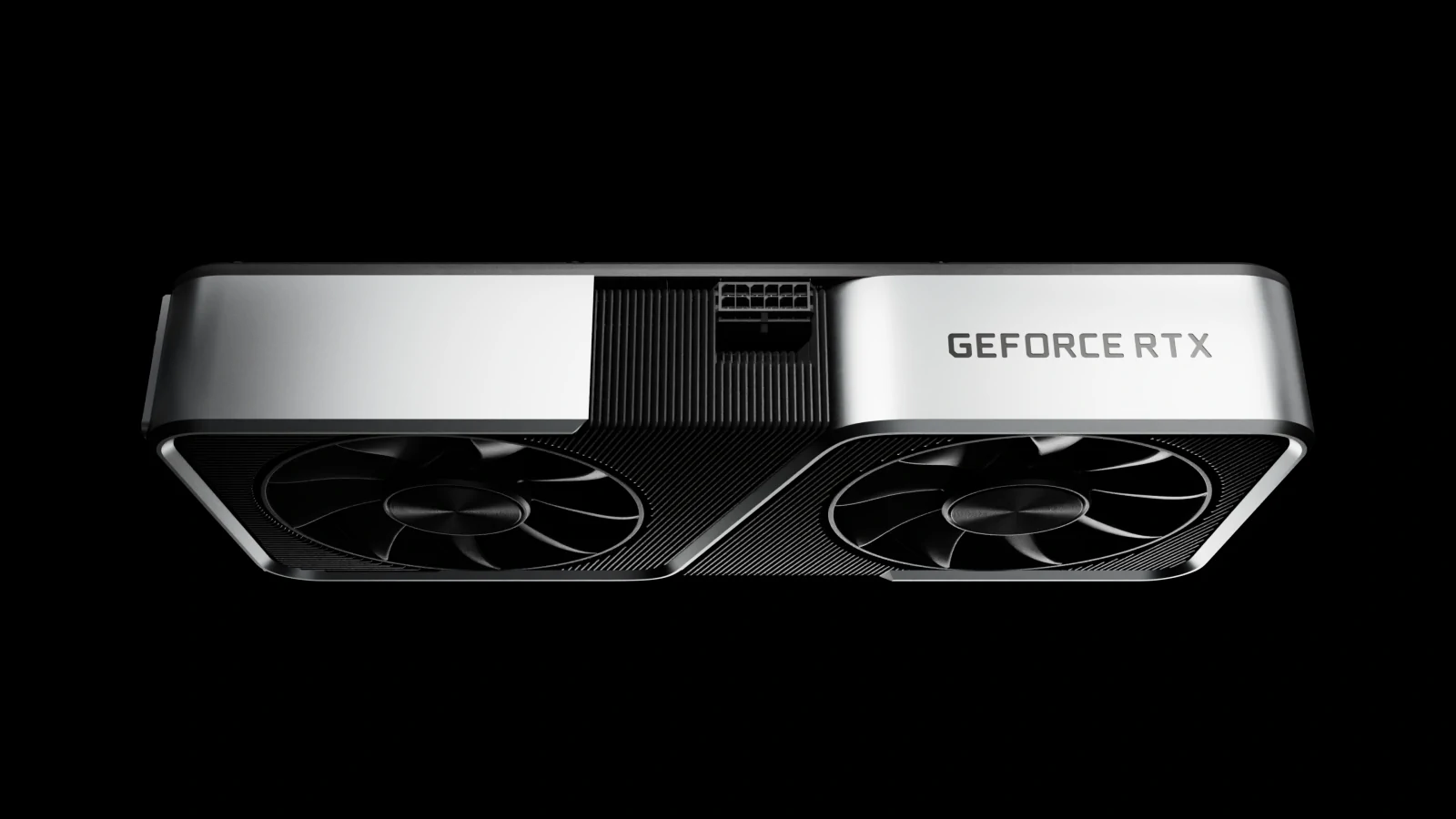

Si hay que creer en las indicaciones actuales -esas indicaciones son señales y teasers de la propia Nvidia-, la siguiente tarjeta gráfica de la compañía se llamará Nvidia GeForce RTX 2080, y se lanzará (o al menos se revelará oficialmente) el 20 de agosto. Pero todavía hay muchas preguntas rondando entre los consumidores, como ¿cuál será el rendimiento de la RTX 2080 y cuánto costará? Aquí vamos a tratar de responder a todas estas dudas.

Ha pasado mucho tiempo desde que Nvidia introdujo su última arquitectura de gráficos para GPUs de juegos. Esa última arquitectura fue Pascal, y ha impulsado todo, desde las GTX 1080 y GTX 1080 Ti de nivel superior hasta las GTX 1050 y GT 1030 de nivel básico, y está en muchas de las mejores tarjetas gráficas que se pueden comprar en este momento. La próxima generación de tarjetas gráficas de Nvidia finalmente se está acercando, usando la arquitectura Turing. Esto es lo que sabemos sobre Turing, la RTX 2080, lo que esperamos en términos de precio, especificaciones y fecha de lanzamiento, y el camino sinuoso que hemos recorrido entre Pascal y Turing.

Surgen los detalles de la GeForce RTX 2080

Anteriormente, ha habido una tonelada de especulaciones y, sí, suposiciones descaradamente erróneas sobre lo que contendría la arquitectura de Turing. Sin embargo, cada una de esas suposiciones estaba equivocada. ¿Todas las supuestas filtraciones y puntos de referencia? Eran falsos. Incluso las conjeturas sobre el nombre estaban equivocadas. El CEO de Nvidia, Jensen Huang, reveló muchos detalles esenciales de la arquitectura de Turing en SIGGRAPH, poniendo finalmente a dormir todos los rumores. Combinado con un vídeo de presentación de las próximas tarjetas GeForce, ahora conocemos la mayoría de los aspectos de la GeForce RTX 2080.

Nvidia ha sido muy reservada sobre sus futuras GPUs en esta ronda, pero con un anuncio anticipado en Gamescom como parte de la celebración de los juegos GeForce de Nvidia, además de los detalles de arquitectura Turing de SIGGRAPH, el nombre está ahora bastante claro. La marca GTX queda descartada, y se remplaza por RTX (para trazado de rayos en tiempo real); los números de serie 11 quedan por fuera, y son sustituidos por los números de serie 20. Nvidia también ha registrado recientemente las marcas GeForce RTX y Quadro RTX, y aunque es posible que las piezas GTX coexistan con las piezas RTX, nos sorprendería que Nvidia optara por esta vía. Al parecer, las nuevas tarjetas empiezan con la GeForce RTX 2080 y se extenderán a otros modelos en los próximos meses.

Pasando a la arquitectura de Turing, aquí es donde Nvidia realmente mantuvo algunas sorpresas ocultas de la fábrica de rumores. La arquitectura Volta tiene algunas características que no estábamos seguros de que se pudieran portar a la línea GeForce, pero Nvidia parece dispuesta a hacerlo y mucho más. La arquitectura Turing incluye los nuevos núcleos Tensor que se utilizaron por primera vez en el Volta GV100, y a continuación añade núcleos RT para ayudar con el trazado de rayos. Esto podría ser importante teniendo en cuenta la reciente creación de Microsoft de la API DirectX Raytracing.

Las GPU profesionales Quadro RTX tendrán ambos tipos de núcleos activados, aunque todavía es posible que Nvidia active un conmutador para desactivar los núcleos Tensor de GeForce; los núcleos RT, por el contrario, tendrán que quedarse, o la marca GeForce RTX no tendría sentido. Sin embargo, Nvidia también reveló un nuevo algoritmo anti-aliasing llamado DLAA, Deep Learning Anti-Aliasing, que implica el uso de núcleos Tensor.

Inicialmente, las GPU Turing se fabricarán utilizando el proceso FinFET de 12 nm de TSMC. Es posible que veamos modelos posteriores de Turing fabricados por Samsung, como fue el caso con las piezas GTX 1050/1050 Ti y GT 1030 Pascal, pero las primeras piezas vendrán de TSMC. Una revelación especialmente sorprendente del anuncio de Quadro RTX es que el diseño superior de Turing contará con 18.600 millones de transistores y medirá 754 mm2. Es un chip enorme, mucho más grande que el GP102 utilizado en el GTX 1080 Ti (471mm2 y 11,8 mil millones de transistores) y sólo ligeramente más pequeño que el Volta GV100. Esto también significa que el nuevo RTX 2080 probablemente seguirá siendo el mejor producto de la serie 20; de lo contrario, Nvidia lo llamaría RTX 2080 Ti.

¿Qué significa en la práctica el paso de 16nm a 12nm? Varias fuentes indican que los 12nm de TSMC es más que todo un refinamiento y ajuste a los 16nm existentes en lugar de una verdadera reducción en los tamaños de las características. En ese sentido, los 12nm son más un término de marketing que una verdadera miniaturización de la oblea, pero las optimizaciones de la tecnología de proceso en los últimos dos años deberían ayudar a mejorar las velocidades de reloj, la densidad de los chips y el uso de la energía (la santa trinidad de los chips: más rápidos, más pequeños y más fríos). El proceso FinFET de 12nm de TSMC también está maduro en este momento, con buenos rendimientos, lo que permite a Nvidia crear un diseño de GPU grande.

También sabemos el número máximo de núcleos, para los núcleos Tensor, los núcleos RT y los núcleos CUDA, o al menos, sabemos la velocidad objetivo para los núcleos RT (Nvidia no ha discutido los detalles de cuántos núcleos RT se utilizan). El diseño superior de Turing permite hasta 4.608 núcleos CUDA, un aumento del 20 por ciento en comparación con la GP102, y un 29 por ciento más que la GTX 1080 Ti. Turing puede proporcionar 16 TFLOPS de rendimiento computacional a partir de los núcleos CUDA (FP32), lo que indica una velocidad de reloj de alrededor de 1700 MHz. También es un 35 por ciento más rápido que la GTX 1080 Ti, si se introduce el mismo rendimiento en una tarjeta GeForce.

Turing también tiene 576 núcleos Tensor con capacidad para 125 TFLOPS de rendimiento FP16 (576 * 64 * 2 * 1700 MHz de nuevo), y los núcleos RT pueden hacer hasta 10 GigaRays/segundo de cálculo de trazado de rayos 25 veces más rápido de lo que se podría hacer con el hardware de propósito general que se encuentra en las GPU Pascal. Por último, la arquitectura Turing introduce la capacidad de ejecutar cargas de trabajo de coma flotante y cargas enteras en paralelo, con 16 billones de operaciones para cada una, lo que debería ayudar a mejorar otros aspectos del rendimiento.

Nvidia parece tener un segundo diseño Turing con hasta 3.072 núcleos CUDA, 384 núcleos Tensor y 6 GigaRays/segundo de núcleos RT. Es posible que sea sólo una versión obtenida a partir del chip más grande, pero eso significaría deshabilitar alrededor de un tercio del diseño y eso no suele ser necesario. Un chip más pequeño sería un buen candidato para la RTX 2060, con la RTX 2070 utilizando una versión obtenida del diseño más grande, o la denominación podría ser diferente. Independientemente de los nombres que usen los chips, Nvidia tendrá la capacidad de desactivar ciertas unidades dentro de cada diseño, permitiendo varios niveles de rendimiento.

Siguiendo adelante, Turing usará memoria GDDR6. Basado en los modelos Quadro RTX, hay dos diseños de chips, uno con una interfaz de 384 bits y 24 GB/48 GB de GDDR6, y el otro con una interfaz de 256 bits y 16 GB de GDDR6. Nvidia está evitando el uso de HBM2, debido a los costes y otros factores, y GDDR6 ofrece un mayor rendimiento que GDDR5X. Mientras que la memoria GDDR6 tiene oficialmente una velocidad objetivo de 14-16 GT/s, y Micron ha demostrado módulos de 18 GT/s, las primeras tarjetas Turing parecen ir con la parte inferior de esa gama y funcionarán a 14 GT/s. Nvidia afirma que Turing utilizará módulos de Samsung de 16 Gb para las tarjetas Quadro RTX, por lo que parece que va a ser todo un éxito y que va a duplicar las capacidades de VRAM para la próxima generación de tarjetas gráficas (a menos que también haya módulos GDDR6 de 8 Gb).

Con una velocidad de transferencia de 14 GT/s, la interfaz de 384 bits tiene 672 GB/s de ancho de banda, y la interfaz de 256 bits proporciona 448 GB/s. Ambos representan mejoras masivas en el ancho de banda en relación con el 1080 Ti y el 1080/1070. También podemos ver diseños de GDDR6 con relojes más altos en el futuro, potencialmente con un bus más estrecho. Nvidia aún no ha profundizado en los aspectos de trazado de rayos, pero sospechamos que será necesario tener más memoria y más ancho de banda de memoria para alcanzar los niveles de rendimiento que Nvidia ha revelado.

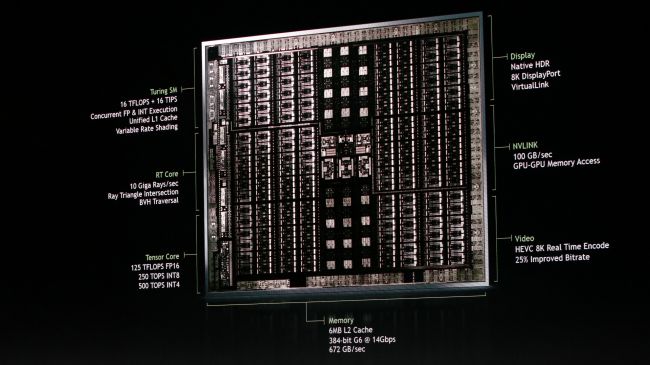

La imagen de arriba muestra una toma de Turing, para el diseño más grande con hasta 4.608 núcleos CUDA. Desde un nivel alto, hay seis grandes grupos que se repiten alrededor del chip. Cada grupo a su vez tiene 24 clusters más pequeños de chips, y dentro de cada uno de esos clusters parece haber 32 bloques pequeños. 24 * 6 * 32 = 4.608, lo que indica que las formas rectangulares más pequeñas son núcleos CUDA.

Si Nvidia se mantiene con sus recientes valores vistos en Pascal y Maxwell, cuatro bloques de 32 núcleos CUDA forman un multiprocesador (SM) de 128 núcleos CUDA, lo que le otorga a Turing 36 SM’s en total. 16 núcleos Tensor en cada SM dan el total de 576 núcleos de tensores también, y cada SM podría venir equipado con dos interfaces de 32 bits para prporcionar la interfaz GDDR6 de 384 bits.

Para la variante más pequeña de Turing, corta el diseño anterior en cuatro grupos principales en lugar de seis. Esto proporciona los 3.072 núcleos CUDA esperados en 24 SM’s, 384 núcleos tensores e interfaz de 256 bits. Hasta ahora todo bien.

La gran pregunta es dónde residen los núcleos RT. No tenemos ninguna cifra de cuántos núcleos RT hay en la arquitectura, sólo un número de rendimiento de 10 GigaRays/seg. Es probable que los núcleos RT estén incorporados en los SM, pero sin una mejor imagen es difícil decir exactamente dónde podrían estar. Los núcleos RT también pueden residir en un área separada, como el bloque central. Tendremos que esperar a que Nvidia nos aclare más sobre este tema.

¿Cuánto costará la RTX 2080?

Con la revelación de la marca RTX y un enfoque en el trazado de rayos en tiempo real así como la nueva tecnología incluida, los precios y otros aspectos se vuelven mucho menos claros. Es posible que Nvidia esté renovando toda su gama de productos para convertir a la RTX 2080 en una GPU de 1.000 dólares, o que retenga una parte de tan alto nivel y, en su lugar, lance la RTX 2080 utilizando el menor de los dos chips mencionados anteriormente. Eso le permitiría a Nvidia seguir con una RTX 2080 Ti o Titan usando la oblea más grande para una actualización de primavera.

El diseño más pequeño de Turing parece una apuesta más segura para una GPU de gama alta de entre 700 y 800 dólares. Incluso con ‘sólo’ 3.072 núcleos CUDA, las mejoras arquitectónicas podrían permitir que este diseño superara a la GTX 1080 Ti en las cargas de trabajo de juegos existentes, con el trazado de rayos como una nueva función que sólo puede realizarse con el nuevo hardware. La capacidad de realizar cargas de trabajo tanto enteras como en punto flotante en paralelo podría ser parte del plan de Nvidia de hacer más con menos. El tamaño de la oblea también sería mucho más manejable, alrededor de 500mm2 en comparación con 754mm2.

Dados los distintos costes de los componentes, no podemos imaginar que una GeForce RTX 2080 de 24 GB (o RTX 2080 Ti) cueste menos de 1.000 dólares, y un precio de 1.500 dólares no está del todo descartado. Nvidia lo califica como el mayor salto en arquitectura en más de una década, desde que lanzó las primeras GPU con núcleos CUDA. Un gran salto en las características a menudo significa un salto similar en los precios.

La mejor suposición es que la RTX 2080 que se lanza en agosto o a principios de septiembre utilizará la oblea Turing más pequeña con 3.072 núcleos. Tendrá una memoria GDDR6 de 16 GB y utilizará la velocidad de reloj y las mejoras arquitectónicas para superar la actual GTX 1080 Ti. La puerta permanece abierta para una futura Ti de la serie 20 que costará más y ofrecerá un rendimiento aún mayor.

¿Cuándo es la fecha de lanzamiento de la RTX 2080?

Nvidia habló de muchos aspectos de la arquitectura Turing en SIGGRAPH, lo que indica que el lanzamiento de los modelos GeForce es inminente. Nvidia también ha planeado una celebración de juegos GeForce para el 20 de agosto en la Gamescom, y esperamos escuchar las especificaciones finales y los precios en ese momento. Si es como el lanzamiento de la 1080 Ti, las revisiones oficiales y el hardware deberían seguir poco después. La información actual sugiere una implementación escalonada de las GPU de la serie 20 como se indica a continuación:

- GeForce RTX 2080: Agosto 30

- GeForce RTX 2070: 27 de septiembre

- GeForce RTX 2060: 25 de octubre

Las fechas de lanzamiento de las 2070 y 2060 se basan en un rumor, por lo que no deben tomarse muy en serio. Sin embargo, es probable que tengan una margen de error de unas pocas semanas y el lanzamiento de todas las GPU de próxima generación ocurra en la temporada de compras navideñas, lo que tiene mucho sentido.

¿Qué hay de la GeForce RTX 2070?

Nvidia tiene una trayectoria muy transitada cuando se trata de lanzamientos de tarjetas gráficas. Comienza con una tarjeta de gama alta como la 780/980/1080, y simultáneamente o poco después lanza la ‘alternativa sensata’ GTX 770/970/1070. Con la serie 900, ambas partes se lanzaron al mismo tiempo, mientras que la serie 700 tenía una diferencia de una semana y la serie 10 tenía un intervalo de dos semanas entre las partes. El despliegue ligeramente escalonado se producirá probablemente con la serie 20, es decir, de 2 a 4 semanas entre los lanzamientos de la 2080 y la 2070.

En cuanto a las especificaciones, de nuevo la práctica estándar de Nvidia es ofrecer una versión recortada del mismo núcleo de la GPU, esencialmente reciclando chips que no pueden funcionar como una 2080 completa y vendiéndolas como 2070’s. La idea es acabar con un rendimiento entre un 20 y un 25 por ciento más lento y un precio entre un 30 y un 35 por ciento más bajo.

Las indicaciones actuales son que la GTX 2070 se enviará a finales de septiembre, junto con las tarjetas GTX 2080 personalizadas. La actual GTX 1070 Ti tiene 2.432 núcleos CUDA, mientras que la GTX 1070 tiene 1.920 núcleos CUDA. El uso de una variante obtenida de la oblea «Turing mini» de 3.072 núcleos CUDA seguiría siendo un gran salto en rendimiento potencial, por no hablar de otras cosas como el trazado de rayos, los núcleos Tensor, etc. Las mejoras arquitectónicas permitirían a Nvidia mantener un número de núcleos similar al de la 1070 Ti, a la vez que ofrecería un rendimiento sustancialmente mejor. No estamos seguros de que una RTX 2070 con 2.560 núcleos CUDA y una interfaz de memoria de 256 bits pueda superar el rendimiento de la GTX 1080 Ti en los juegos actuales, pero cualquier cosa que utilice los núcleos RT para el trazado de rayos será una victoria fácil.

En términos de memoria, la GTX 2070 también utilizará GDDR6, ya que la placa de circuito impreso puede ser la misma para la 2070 y 2080. Velocidades de reloj ligeramente más bajas para la RAM también son típicas, o quizás Nvidia deshabilitará una de las interfaces de memoria (por ejemplo, 12 GB de GDDR6 con una interfaz de 192 bits). Las nuevas tarjetas no deberían tener menos memoria que la generación actual, así que es probable que sean de 12 GB o 16 GB. Espera que los precios iniciales de la 2070 estén en el rango de $450 a $500.

¿Habrá una tarjeta RTX 2080 Ti o RTX Titan?

Casi con toda seguridad, aunque se desconoce si se lanzará tarde o temprano. La Titan V existe, pero está en una categoría diferente y carece de los núcleos RT. La Titan V seguirá siendo una opción para el aprendizaje automático y la inteligencia artificial, pero una nueva RTX Titan debería desplazarla con el tiempo con un rendimiento similar y un mejor rendimiento de trazado de rayos, y quizás incluso a un precio más bajo.

Nvidia ya ha hablado de los modelos Quadro RTX 6000 y 8000, que utilizan una oblea masiva, casi tan grande como el de la GV100. La creación de una RTX Titan con especificaciones similares a las de Quadro RTX 6000 pero sin algunas de las funciones de Quadro (como los controladores profesionales para aplicaciones CAD/CAM) tiene sentido. Tener una RTX Titan con 24GB GDDR6 a un precio de $1,499 que supera a la Titan V hará que los precios extremos parezcan casi justificables. Y con NVLink, la compatibilidad con SLI puede seguir existiendo, algo de lo que carece la Titan V.

Las tarjetas Quadro RTX no comenzarán a enviarse sino hasta el cuarto trimestre de 2018, lo que sin duda está a solo seis semanas de distancia en este momento. Mantener en reserva una nueva Titan para un lanzamiento de primavera estaría en línea con el comportamiento pasado de Nvidia, y no hay mucho espacio para ir más allá del diseño actual de Turing de 4.608 núcleos sin un encogimiento a 10 nm o incluso 7 nm. Las 1080 y 1070 han existido por más de dos años, y probablemente pasarán más de dos años antes de que las tarjetas de la serie 20 sean reemplazadas, por lo que Nvidia necesita un ritmo de despliegue de nuevo hardware.

¿Podría un RTX 2080 Ti o RTX Titan lanzarse en 2018? Posiblemente sí. Y los nombres, los núcleos RT y otros elementos sorpresa de las próximas tarjetas de la serie 20 prueban que Nvidia está dispuesta a desviarse del comportamiento pasado. Cuando estén disponibles las nuevas tarjetas RTX 2080 Ti y Titan de rendimiento extremo, esperamos que cuesten bastante más que las actuales GTX 1080 Ti y Titan Xp.